© AFP/Fabrice Coffrini

Treffen der "Singularity University" in Berlin: Wie die ferngesteuerten Kakerlaken

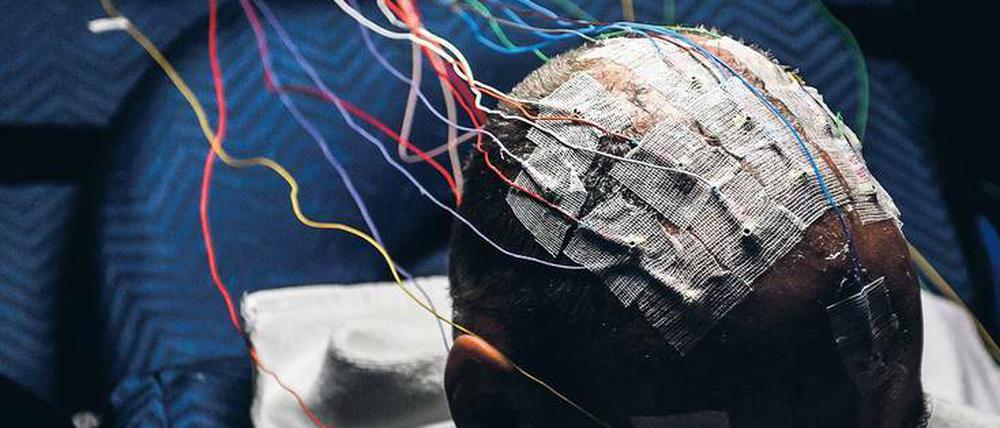

Im Grunde sind Computer und Menschenhirne längst vernetzt, etwa über Tastaturen. Aber deutlich mehr ist denkbar.

Die Veranstaltung hat schon einmal einen hochtrabend, aber auch interessant klingenden Namen: Am Montag und Dienstag dieser Woche findet im Berliner Congress Center der „Germany Summit“ der „Singularity University“ statt. Dort diskutieren Experten aus aller Welt über die Konsequenzen moderner Technologien. Darunter sind solche, die die Grenzen zwischen Lebewesen und Maschinen verwischen.

Chip auf der Schabe

Die „Singularity University“ ist allerdings keine Universität im klassischen Sinne. Das gemeinnützige Unternehmen mit Sitz am Nasa Research Park Campus im Silicon Valley versteht sich eher als globale Community, die nichts anderes als den Lauf der Geschichte beeinflussen will. „Wir wollen die weltweiten Verantwortungsträger über die ökonomischen und ethischen Konsequenzen exponentieller Technologien aufklären“, sagt Neil Jacobstein, Leiter der Sparte Robotik und künstliche Intelligenz der Singularity University. Zu diesen Technologien gehörten auch solche, die versuchen, Nervensysteme von Tieren oder auch Menschen mit Maschinen zu koppeln. „Hirn-Computer-Schnittstellen spielen eine zentrale Rolle“, sagt Jacobstein.

Ganz neu ist die Idee nicht. Schon vor rund 20 Jahren stellte etwa der Ingenieur Isao Shimoyama von der Universität Tokyo eine „ferngesteuerte Küchenschabe" vor. Er hatte je eine Elektrode an die Nervenbahnen beider Antennen des Insekts angeschlossen. Über diese Schnittstelle konnte Shimoyama der Schabe mit leichten Stromsignalen Hindernisse vorgaukeln und so ihre Laufrichtung per Fernsteuerung nach Belieben steuern.

Fünf Jahre später betraten die ersten ferngesteuerten Ratten die Bühne der Hirnforschung. Das Team von John Shapin von der New York State University hatte den Tieren Elektroden direkt in den Teil der Hirnrinde eingepflanzt, der die Sinnessignale von den Barthaaren verarbeitet. Statt also lediglich die Antennen der Ratten zu reizen, manipulierten die Forscher die Wahrnehmung des Tieres direkt im Gehirn. Eine weitere Elektrode hatten sie ins Belohnungszentrum der Ratte gepflanzt. Folgte das Tier den Steuersignalen wie gewünscht, löste diese Elektrode dort positiv wahrgenommene Signale aus. Und das wirkte: Nach nur zehn Trainingseinheiten konnten die Forscher die Nager Kurve um Kurve durch einen schwierigen Hindernisparcours mit Leitern, Röhren und kleinen Toren lenken - eine Dressur im Schnellverfahren.

Ratte sieht (Infra)rot

Dass man dem Gehirn sogar neue Sinneskanäle hinzufügen kann, zeigt ein Experiment von Miguel Nicolelis und seinem Team von der Duke University in North Carolina. Im Jahr 2015 berichteten sie von einer Ratte, die sich an Infrarotlicht orientieren konnte. Die Forscher hatten dem Tier Elektroden in jenen Teil der Hirnrinde implantiert, der Berührungen verarbeitet. Die Elektroden waren an drei Infrarotsensoren gekoppelt, die die Ratte auf dem Kopf trug. Tatsächlich begann diese Cyborg-Ratte nach nur vier Tagen Training, Infrarotlampen in ihrem Käfig zu erkennen und entdeckte mit deren Hilfe Nahrung. Ihr Gehirn hatte offensichtlich gelernt, die neuen Sinnesdaten zu interpretieren.

Auch beim Menschen werden Hirn-Computer-Schnittstellen seit einigen Jahren genutzt. Ein Beispiel ist die heute weit verbreitete Tiefenhirnstimulation für Parkinson-Patienten. Dabei hemmt eine Elektrode eine Gruppe von Nervenzellen in den sogenannten Basalganglien, einem Netzwerk tief im Gehirn, das über die Ausführung geplanter Handlungen entscheidet.

Es gibt aber auch komplexere Anwendungen, bei denen Signale aus der Hirnrinde von Computern interpretiert werden. Im Februar 2016 zum Beispiel gelang es Ärzten von der Johns Hopkins Universität im amerikanischen Baltimore mittels eines Implantats mit 128 Elektroden, Signale aus dem motorischen Kortex eines Patienten so genau auszulesen, dass er damit die Finger eines Roboterarms einzeln steuern konnte.

Stehen wir also heute schon kurz davor, unsere Gehirne direkt an Computer anzukoppeln? „Es ist gar keine Frage, dass wir direkte Hirn-Computer-Schnittstellen nutzen werden“, sagt Jacobstein. „Klar ist aber auch, dass es noch einige Zeit dauern wird, bis dies für die Anwendung am Menschen erlaubt sein wird.“ Es gebe zwar schon heute Firmen wie Neuralink von Elon Musk, die aktiv an Breitband-Schnittstellen zum menschlichen Kortex arbeiten. „Das sind aber eher Visionen als ein anwendbares Produkt“, sagt Jacobstein.

Allerdings kann man die Verkopplung von Mensch und Computer auch aus einem anderen Blickwinkel betrachten. Tastaturen, Bildschirme und Virtual-Reality-Brillen sind in einem gewissen Sinne auch Hirn-Computer-Schnittstellen. Und statt Computerteile in den Menschen zu integrieren, kann man schließlich auch versuchen, den Menschen in Roboter zu integrieren. Im Februar 2016 beantragte das kanadische Unternehmen D-Wave ein Patent für ein Exoskelett, mit dem ein Mensch oder ein Affe einen Roboter-Avatar fernsteuern kann.

Visuelle Daten sollten demnach über eine 3D-Brille an den Roboter-Piloten übertragen werden, mechanische Inputs über das Exoskelett selbst. Das Besondere an dem Ansatz ist, dass ein neuronales Netz von den Piloten lernen soll, bestimmte Aufgaben autonom zu erledigen. Als Anwendung dieses halbautonomen Roboters wären einfache Aufgaben denkbar, etwa Hausarbeit oder Kisten schleppen in einer Lagerhalle.

Noch hat D-Wave diese Vision nicht verwirklicht. Der ehemalige Chef des Unternehmens hat die Idee jedoch mit in seine neue Firma gebracht. Heute beschäftigt „Kindred Robots“ sechs menschliche „Piloten“, die Roboter in mehreren nordamerikanischen Lagerhallen vom Firmensitz in Toronto aus steuern. Sie tun das mit einer Computer-Maus (der klassischen Variante), die man dreidimensional bedienen kann, und mehreren Flachbildschirmen.

Schnittstelle an der Großhirnrinde statt Tastatur

Auch Cyborg-Tiere könnten in Zukunft für Aufgaben eingesetzt werden, für die Roboter allein noch zu dumm sind. So stellte eine japanische Forschungsgruppe Ende 2016 eine Motte vor, die ein Spielzeugauto per Geruch steuern konnte. Das Auto hatte ein Cockpit, in dem die Motte mit dem Rücken an einer kleinen Stange fixiert war. Dabei stand sie auf einem Ball, der auf einem Luftkissen schwebte. Ein optischer Sensor erfasste die Bewegungen des Balls und setzte sie in Bewegungen des Autos um. Lief die Motte los, fuhr auch das Auto in die Richtung, die die Motte gewählt hatte. So konnten die Mottentrainer ihren „Insekten imitierenden Roboter“ auf eine Geruchsquelle zufahren lassen. Als mögliche Anwendungen solcher Biobots gelten etwa Rettungs- und Militäreinsätze. Man muss also nicht zwingend direkt in das Nervensystem eingreifen, wenn man das Gehirn eines Lebewesens vor eine Maschine spannen will.

„Es ist wichtig, den Menschen den Unterschied klarzumachen zwischen einer wissenschaftlich begründeten technologischen Vision und einer bereits existierenden Anwendung und deren Weiterentwicklung“, sagt Jacobstein. Es gebe zwar schon heute viele Beispiele für Hirn-Computer-Schnittstellen, die am Menschen eingesetzt werden. „Bisher aber sind die auf Anwendungen bei motorischen Behinderungen beschränkt und weit entfernt von den Multi-Milliarden-Dollar-Industrien wie etwa Virtual Reality", sagt Jacobstein. Das solle aber nicht heißen, dass er etwas gegen direkte Hirn-Computer-Schnittstellen habe. „Ich würde es durchaus begrüßen, wenn wir diese klobigen Keyboards loswerden“, sagt er.

Er glaubt aber nicht, dass sich dieser Wunsch – für manche mag er auch nach Albtraum klingen – in den kommenden zehn Jahren erfüllen wird.

- showPaywall:

- false

- isSubscriber:

- false

- isPaid:

- showPaywallPiano:

- false