© Abb.: CSL/KIT

Ins Gehirn geschaut: Forscher rekonstruieren Sprache aus Hirnströmen

"Zum ersten Mal können wir das Gehirn beim Sprechen beobachten“: Mit einer neuen Technik könnten Locked-in-Patienten künftig mit der Außenwelt kommunizieren, hoffen Wissenschaftler.

Forscher des Karlsruher Instituts für Technologie (KIT) und aus den USA haben direkt aus Gehirnströmen Laute, Wörter und ganze Sätze rekonstruiert. Sie haben dafür Daten der Gehirnströme von sieben Epilepsie-Patienten in den USA ausgewertet: Ihnen lag während des Sprechens ein Elektrodennetz direkt auf der Großhirnrinde des zur Epilepsie-Behandlung ohnehin freigelegten Gehirns. Mit Elektroden, die von außen am Kopf angelegt werden und so die elektrische Aktivität des Gehirns messen, sind solche spezifischen Aufzeichnungen noch nicht möglich.

Datenbank mit 50 Lauten

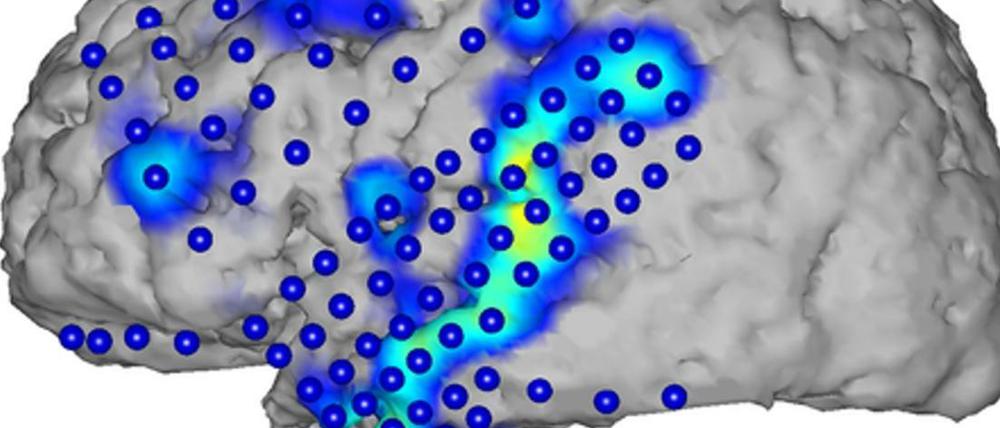

„Zum ersten Mal können wir das Gehirn beim Sprechen beobachten“, sagt die KIT-Informatikerin Tanja Schultz. Die Forscher können nun zusehen, wie das Gehirn den Sprechvorgang plant und dann die Muskeln der Artikulationsorgane über die Neuronen in der Großhirnrinde aktiviert, bevor die eigentliche Sprache hörbar wird. Sichtbar gemacht wurden die Aktivitäten mithilfe von Farben. „Die neuronale Aktivität auf der Großhirnrinde kann farblich dargestellt werden“, erläutert Schultz. „Rote und gelbe Farben bedeuten hohe Aktivitäten an der Stelle im Gehirn, blaue Farben eine niedrigere Aktivität.“ Die Patienten waren zuvor gebeten worden, bestimmte Texte zu sprechen, etwa eine Rede des ehemaligen US-Präsidenten John F. Kennedy oder auch einfache Kinderreime. Die Forscher wussten also zunächst, welche Laute wann gesprochen wurden und legten mithilfe der dabei gemessenen Hirnströme Datenbanken mit Prototypen von etwa 50 verschiedenen Lauten an.

Genauigkeit liegt "über dem Zufall"

Auf Basis von Algorithmen aus der automatischen Spracherkennung gelang es anschließend, allein anhand der Gehirnströme zu verstehen, was gesagt wurde. Dazu werden Laute im Kontext von Wörtern und ganzen Satzphrasen betrachtet. „Wir bekommen damit aussagekräftige Ergebnisse, die in der Erkennungsgenauigkeit zwar noch weit von der akustischen Spracherkennung entfernt sind, aber sehr deutlich über dem Zufall liegen“, sagte Schultz. Die Ergebnisse wurden im Fachmagazin „Frontiers in Neuroscience“ veröffentlicht.

Die Technik könnte Locked-in-Patienten helfen

Knackpunkt der vierjährigen Forschung ist bislang die geringe Datenbasis von nur sieben Patienten, von denen jeweils höchstens fünf Minuten Sprache vorliegen. Die Wissenschaftler wollen ihre Analysen daher ausweiten. Neben einem besseren Verständnis der Sprachprozesse könnte der sogenannte Brain-to-Text „ein Baustein sein, um Locked-in-Patienten zukünftig eine sprachliche Kommunikation zu ermöglichen“. Beim Locked-in-Syndrom sind Menschen zwar bei Bewusstsein, aber fast vollständig gelähmt und unfähig, sich der Außenwelt verständlich zu machen. (dpa)

- showPaywall:

- false

- isSubscriber:

- false

- isPaid:

- showPaywallPiano:

- false