© Captionbot, Fotovorlage: iStock/GettyImages

Wenn der Algorithmus versagt: So dumm ist Künstliche Intelligenz

Oft ist Künstliche Intelligenz noch gar nicht so clever, sondern produziert haarsträubende Fehler und gefährliche Verwechslungen.

Selbstlernende Software hat in den vergangenen zwei Jahren enorme Sprünge gemacht. So waren selbst Experten überrascht, als die Google-Tochter Deepmind den besten Go-Spielern der Welt nicht den Hauch einer Chance ließ. Das asiatische Brettspiel ist viel komplexer als Schach und erfordert durch die Vielzahl an Kombinationen mehr Intuition als Vorausberechnung, daher waren alle Beobachter davon ausgegangen, dass es noch Jahre dauert, bis Computer die besten Menschen besiegen könnten. Doch mit sogenannten neuronalen Netzen, die das Lernen des Gehirns nachbilden, trainierte das Deepmind- Team die Software. Es lernte die Regeln und spielte unzählige Partien gegen sich selbst. So brachte sich Alpha Go Züge bei, über deren Sinn die Go-Großmeister immer noch grübeln, allein sie führten zum Erfolg.

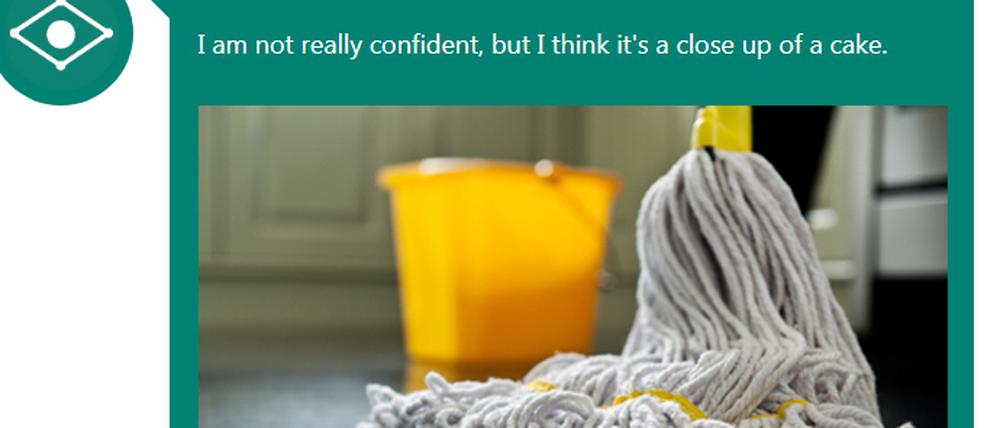

Microsoft verwechselt Wischmopp mit Kuchen

Doch genauso oft produzieren die vermeintlich intelligenten Systeme auch haarsträubende Fehler. Wie schwierig es der Software beispielsweise noch fällt, Bilder zu erkennen, zeigt das Microsoft-Programm Captionbot. „Ich kann den Inhalt jedes Fotos verstehen und werde versuchen, es so gut zu beschreiben wie ein Mensch“, wirbt der Bilderbot auf seiner Website. Das klappt in vielen Fällen zwar auch ganz gut, doch genauso oft liegt die Künstliche Intelligenz (KI) ziemlich daneben. Lädt man beispielsweise das Foto eines Wischmopps hoch, erklärt der Bot: „Ich bin mir nicht ganz sicher, doch ich denke, das ist ein Kuchen.“ Schlimmer noch, das Programm lernt offenbar auch kaum dazu. So machten sich viele schon beim Start im Frühjahr 2016 über die Interpretation eines Fotos lustig, auf dem Barack Obama seine Frau Michelle eng umschlungen hält. „Ich denke, es ist ein Mann mit Anzug und Krawatte, der auf einem Handy spricht“, erklärte die Software. Und heute verwechselt das Programm Michelle Obama immer noch mit einem Telefon.

Gefährliche Verwechslung bei Googles Bilderkennung

Bei einem anderen Foto glaubt der Captionbot, es wäre eine Person, die auf einem Tisch sitzt. Das ist zwar etwas näher dran als die Konkurrenzintelligenz von Google, aber trotzdem ziemlich daneben. Denn auf dem Foto ist eine farbige Plastikschildkröte zu sehen. Wissenschaftler des Massachusetts Institute of Technology (MIT) haben sie mit einem 3D-Drucker hergestellt, um zu zeigen, wie anfällig Bilderkennungssysteme sind. Die Künstliche Intelligenz von Google hielt die Schildkröte mit einer Wahrscheinlichkeit von 90 Prozent für ein Gewehr. In anderen Fällen des Tests wurde eine Katze mit Guacamole verwechselt und ein Baseball für Espresso gehalten.

Die Probleme sind nicht neu. So hatten japanische Wissenschaftler von der Universität Kyushu nachgewiesen, dass es schon genügen kann, wenige Pixel in einem Bild zu verändern, um die Algorithmen komplett zu verwirren. Oft waren dafür nur drei oder fünf Bildpunkte nötig, zum Teil genügte sogar ein falscher Pixel.

Risiken für selbstfahrende Autos

Solche Experimente können auch in der Realität gefährliche Folgen haben. Schließlich befürworten auch in Deutschland viele Politiker und Bürger den Einsatz von Videoüberwachung mit intelligenter Bilderkennung. Doch wenn Algorithmen Schildkröten mit Waffen verwechseln, wären fehlerhafte Alarmmeldungen keine Überraschung. Fast noch riskanter sind mögliche Fehler bei selbstfahrenden Autos. Auch hier ist die Bilderkennung zentral. Doch wie schnell die versagen kann, zeigt eine gemeinsame Studie von Wissenschaftlern mehrerer US-Universitäten. Sie haben dafür kleine schwarze und weiße Streifen auf Stoppschilder geklebt. Zum Teil schrieben sie damit die Worte „Love“ oder „Hate“. Obwohl der Stop-Schriftzug selbst noch vollständig erkennbar war, wurden 73 Prozent der Bilder falsch klassifiziert. Ähnliche Fehler könnten durch Graffiti oder mit Stickern beklebte Schilder auch im echten Straßenverkehr passieren.

Während sich manche Forscher um die Zukunft der Menschheit durch allmächtige Algorithmen sorgen, fürchten andere solche Schwächen viel mehr. „Sorge macht mir dumme KI“, sagt Toby Walsh, ein australischer Professor, der derzeit an der TU Berlin lehrt. Im Augenblick sei auf die Systeme noch zu wenig Verlass, doch viele würden ihnen schon zu sehr vertrauen.

- showPaywall:

- false

- isSubscriber:

- false

- isPaid:

- showPaywallPiano:

- false