© picture alliance/dpa/Boris Roessler

Künstliche Intelligenz: Wie menschlich, ach, ist mir zumute

Die Philosophin Catrin Misselhorn fragt nach dem Einfühlungsvermögen künstlicher Intelligenz.

Können künstliche Intelligenzen empathisch sein? Und sind empathische Roboter oder humanoide Maschinen überhaupt erstrebenswert? Die Göttinger Philosophin Catrin Misselhorn, die 2018 bereits wichtige „Grundfragen der Maschinenethik“ diskutierte, führt mit ihrem neuen Buch in die recht junge Disziplin der emotionalen KI ein.

[Catrin Misselhorn: Künstliche Intelligenz und Empathie. Reclam Verlag, Stuttgart 2021. 150 Seiten, 6 €.]

Vieles, das künstliche Intelligenz genannt wird, kann dieses Versprechen nicht halten. Umso wichtiger ist es, das definitorische Panorama abzustecken. Gleichzeitig wird die Referenzgröße, also die menschliche oder natürliche Intelligenz, mit jeder neuen Errungenschaft reevaluiert. Hieß es vor einigen Jahren, ein Programm sei dann intelligent, wenn es einen Menschen im Schach besiegen könne, war wenig später schon von Go die Rede. Nun kommt die Empathie ins Spiel.

Unglaubwürdig wird die Neudefinition von Begriffen, wenn der Mensch als das grundlegend Gute gesetzt wird. Übersehen wird dabei, dass Algorithmen und schließlich KIs genau deswegen sexistisch, rassistisch oder transfeindlich sein können, weil Menschen es eben auch sein können. Empathiefähigkeit allein ist also keine hinreichende Bedingung für ein gleichberechtigtes, diskriminierungsfreies oder einfach gutes Zusammenleben.

Ein Bot mit rassistischen Tweets

So interessierten sich viele für das Phänomen des von Microsoft entwickelten Twitter-Bots Tay, der 2016 nach nur 16 Stunden Betriebszeit wegen rassistischer Äußerungen abgeschaltet wurde. Dass hinter ihm jedoch Tausende rassistischer Tweets von Menschen standen, von denen er gelernt hatte, wurde schnell zweitrangig. Man kann KIs zwar mit menschlichen Daten füttern, die sie eigenständig verarbeiten, aber man kann ihnen noch keine Fairness einprogrammieren.

Misselhorn macht immer wieder auf solche strukturellen Probleme aufmerksam. Die Entwickler*innen berufen sich zum Beispiel gern auf universalistische Theorien von Emotionen, wie sie Paul Ekman in den 1960ern entwickelte. Der amerikanische Psychologe ging davon aus, dass es eine bestimmte Anzahl von gut abgrenzbaren Gefühlen gebe, denen sich Mimik und Gestik zuordnen lassen. Eine KI mit entsprechenden Bildern, Tonlagen und emotional belegten Wörtern zu speisen, um sie so bestimmte Emotionen wiedererkennen zu lassen, scheint vergleichsweise einfach zu sein. Allerdings können KIs weiße Menschen wesentlich besser erkennen als Schwarze Menschen, was sich auf die Erkennbarkeit der Emotionen übertragen lässt.

Neuere Ansätze, die sich stärker mit kulturellen und sozioökonomischen Zusammenhängen von Emotionen, Emotionsausdrücken und deren Lesbarkeiten beschäftigen, bleiben bei Misselhorn außen vor. Dabei würden diese differenzierteren Theorien ihre der empathischen KI skeptisch gegenüberstehende Argumentation stützen.

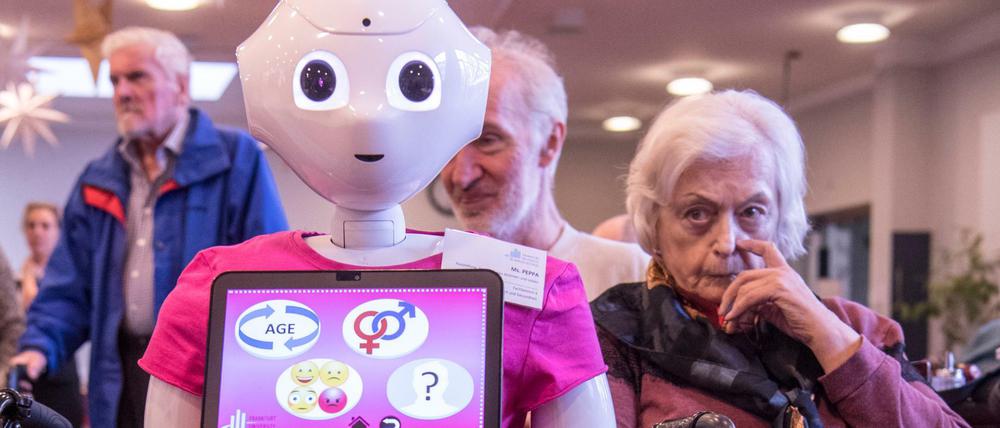

Eingesetzt werden sollen die empathischen Intelligenzen in fast allen sozialen Bereichen, unter anderem in Bildung, Pflege, Politik, Diagnostik sowie bei sexuellen Interessen, die zu kriminellen Handlungen führen können – etwa im Fall der Pädophilie. Trainiert werden die Systeme mit gesichts- und stimmbasierter Emotionsanalyse sowie Sprachbedeutung. Pflegeroboter sollen so zum Beispiel erkennen können, wenn Patient*innen traurig sind, mit ihnen darüber ins Gespräch kommen und sie aufheitern.

Vertrauen zur Maschine

Menschliche Testpersonen empfinden solche humanoiden Roboter und KIs laut Befragung tatsächlich als empathisch. Häufig wird einer Diagnostik-KI im vertraulichen Gespräch sogar mehr anvertraut als einem menschlichen Therapeuten. Dass Menschen diese Maschinen als empathisch empfinden, bedeutet jedoch nicht, das betont Misselhorn wiederholt, dass sie auch empathisch sind. Den Unterschied von „Empathie simulieren“ und „Empathie haben“ unterstreicht Misselhorn auch deswegen, weil sie davon ausgeht, dass „Empathie haben“ für moralisches Verhalten unabdingbar ist. Folglich spricht sie KIs die Fähigkeit zu moralischem Verhalten ab.

Das ist ein wichtiger Punkt. Denn wie gestaltet sich das Zusammenleben von humanoiden Maschinen und Menschen, wenn der einen Gruppe moralisches Verhalten zugeschrieben wird, der anderen aber weder dies noch „echte“ Empfindungen? Die Fähigkeit zur Moral wird bei KIs hinterfragt, sie wird aber unhinterfragt mit Menschen verknüpft. Das verzerrt die Debatte dann, wenn es in Anbetracht von KI nicht mehr um die moralische Haltung einzelner Menschen oder Gruppen geht, sondern allein der Dualismus von moralischen und nichtmoralischen Wesen etabliert wird.

[Wenn Sie aktuelle Nachrichten aus Berlin, Deutschland und der Welt live auf Ihr Handy haben wollen, empfehlen wir Ihnen unsere App, die Sie hier für Apple- und Android-Geräte herunterladen können.]

Immer wieder kontrovers ist die das Buch ausleitende Frage des Umgangs mit Sexrobotern. Während Sophie Wennerscheid in ihrem Buch „Sex machina“ in humanoiden, aber vor allem auch nicht-humanoiden (Sex-)Robotern neue Möglichkeiten von Zuneigung, Geborgenheit und Lust sah, fürchtet Misselhorn, dass Sexroboter den Menschen desensibilisieren könnten: Wer sich an Robotern vergehe, könne Hemmschwellen abbauen und in einem nächsten Schritt vielleicht auch Menschen missbrauchen. Diese Sorge ist aus der Diskussion um gewalttätige Videospiele vertraut. Immer wieder wurden Massenschießereien mit Desensibilisierungen durch Computerspiele in Verbindung gebracht.

„Künstliche Intelligenz und Empathie“ ist ein Beitrag zu einer der heute wichtigsten Fragen der Ethik, über deren Entwicklung und Verantwortung sich kürzlich auch der Deutsche Ethikrat austauschte. Dabei lohnt es sich, beim Blick auf fehlbare KI den fehlbaren Menschen nicht zu übersehen. Gerade vor diesem Hintergrund ist die Unterscheidung zwischen simulierter und echter Empathie komplexer, als es die kompakten Denkanstöße von Misselhorn auffangen. Denn obwohl es sicherlich nicht zielführend ist, zu rein behavioristischen Modellen zurückzukehren, kann es uns nicht gleichgültig sein, wann wir Empathie in Anderen erkennen.

Nina Tolksdorf

- showPaywall:

- false

- isSubscriber:

- false

- isPaid:

- showPaywallPiano:

- false